Clase 1

ASPECTOS INTRODUCTORIOS DE COMPUTACIÓN NEURONAL

· Dos Definiciones de Computación Neuronal (Hecht-Nielsen)

· Definición de Computación Neuronal (Teuvo Kohonen)

· Definición de Computación Neuronal (en Ingeniería)

· Características Básicas de las Redes Neuronales Artificiales

· Propiedades de la Redes Neuronales Artificiales

· Aprendizaje en Computación Neuronal

· Ejemplo de Red Neuronal Natural

· Esquema de una Neurona y de la Sinapsis

· Diagrama en Bloques de un Sistema de Procesamiento Basado en una Red Neuronal

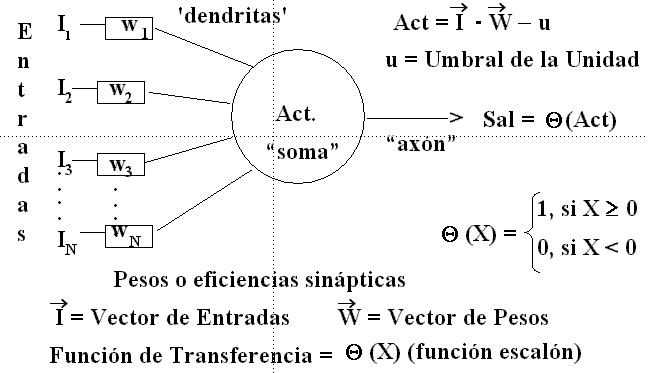

· Primer Modelo Histórico de una Red Neuronal Artificial (Modelo de McCulloch y Pitts, 1943)

· Aspectos y Omisiones del Modelo de McCulloch y Pitts

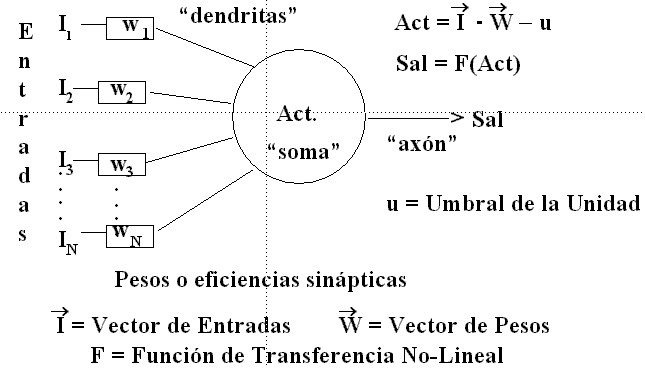

· Esquema de una Unidad Básica de Proceso

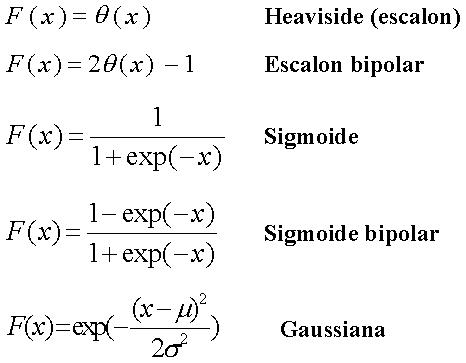

· Algunas Funciones de Transferencia Comúnmente Utilizadas

Dos Definiciones de Computación Neuronal (Hecht‑Nielsen)

(i) Las redes neuronales artificiales son arreglos de unidades de procesamiento (UU. P. o neuronas) interconectadas entre sí. Las UU. P. puede tener muchas entradas, pero sólo tienen una salida. Las entradas de las UU. P. son copias de las señales de salida de otras UU. P. o señales externas. La dinámica de las UU. P. se especifica a través de ecuaciones diferenciales ordinarias de primer orden en la variable de salida o, en el caso de tiempo discreto, a través de ecuaciones en diferencias.

(ii) Las redes neuronales artificiales son simulaciones de estructuras cognitivas de procesamiento de información, basadas en modelos de las funciones cerebrales. En un contexto más de ingeniería, constituyen un sistema dinámico en extremo paralelo, con la estructura de un grafo dirigido, que ejecuta el procesamiento de la información en términos de su respuesta o reacción a una entrada o estímulo externo, continuo o discreto.

Definición de Computación Neuronal (Teuvo Kohonen)

Las redes neuronales artificiales son estructuras interconectadas de unidades de procesamiento simples (generalmente adaptables). Estos dispositivos son masivamente paralelos y de organización jerárquica. Deben interactuar con los objetos del mundo real de la misma forma en que lo hace el sistema nervioso biológico.

Definición de Computación Neuronal (en Ingeniería)

Las redes neuronales artificiales son modelos matemáticos multiparamétricos no‑lineales, capaces de inducir una correspondencia entre conjuntos de patrones de información (la relación estímulo‑respuesta). El procesamiento de la información se realiza a la manera de los sistemas neuronales biológicos.

Características Básicas de las Redes Neuronales Artificiales

i) Estructura de grafo dirigido.

ii) Una unidad de procesamiento en cada vértice del grafo.

iii) Las aristas o enlaces indican el flujo de la información.

iv) Un peso sináptico por enlace.

v) Cada U. P. posee una función de transferencia (o función de activación) no‑lineal.

vi) El estado del sistema lo define el conjunto de actividades de las UU. P.

Las Redes Neuronales Artificiales (R. N. A.) constituyen poderosos dispositivos de cómputo, en gran parte por las siguientes propiedades:

i) Están conformadas por un conjunto de unidades de procesamiento bien sencillas que se comunican a través de una vasta red de interconexiones con pesos sinápticos adaptables (variables).

ii) Las memorias (información) se almacenan o representan en el patrón de pesos de las interconexiones de las UU. P. El procesamiento de la información ocurre basándose en la variación del patrón de actividades de las UU. P., distribuido a lo largo de todo el dispositivo.

iii) Las redes neuronales no se programan, más bien aprenden o se entrenan en la tarea que ha de computarse. En algunos casos es posible la implementación de dispositivos capaces de aprendizaje independiente o autónomo. Ciertas redes aprenden por ensayo y error.

iv) No operan según el esquema tradicional de computación (von Neumann: un sistema de memoria, una unidad de proceso central más un programa externo que determina la operación). En una R. N. A. la operación viene determinada por las siguientes propiedades:

La función de transferencia (o

función de activación) de las UU. P.

El detalle de la estructura del

conjunto de conexiones sinápticas entre las UU. P.

La regla dinámica de la red.

La ley de aprendizaje o de entrenamiento que se aplica.

v) Una R. N. A. actúa naturalmente como una memoria asociativa. Es decir, esencialmente asocia entre sí los patrones con los cuales se entrena, agrupando físicamente en su estructura patrones similares. Una R. N. A. que opere como memoria asociativa tiene acceso a la información por contenido, en tal sentido es capaz de recuperar información a partir de estímulos incompletos, ruidosos o parcialmente erróneos (estímulos contaminados).

vi) Una R. N. A. tiene la capacidad de generalización; es decir, es capaz de aprenderse las características de una categoría general de patrones, basándose en una serie de ejemplos específicos de la categoría.

vii) Son, en gran medida, tolerantes a las fallas de sus componentes. Una R. N. A. mantiene un grado satisfactorio de ejecución aun luego de remover o deteriorar una fracción significativa de sus UU. P. o interconexiones. A medida que el deterioro progresa, el desempeño de estos dispositivos empeora lenta y suavemente, esto suele denominarse “degradación graciosa”.

viii) Pueden operar naturalmente como procesadores de patrones espacio‑temporales.

ix) Pueden poseer la propiedad de autoorganización, es decir algunas R. N. A. son capaces de organizar y adaptar sus conexiones sinápticas sin necesidad de que se les provea durante el entrenamiento de instrucciones acerca de qué aprender.

En la Computación Neuronal pueden distinguirse dos clases de dispositivos:

i)

Con

formación adaptable de los enlaces entre las UU. P.

ii)

De

parámetros invariantes en el tiempo.

La única alternativa

para incluir la habilidad de aprender es la (i).

Aprendizaje: Mejoramiento progresivo de la ejecución (desempeño) del sistema, de acuerdo con algún criterio de calidad.

Se distinguen:

|

SUPERVISADO NO-SUPERVISADO |

Únicamente modificación de los parámetros |

|

|

|

|

AUTOORGANIZATIVO |

Determinación

de la estructura u orden del sistema dinámico |

A cada unidad de proceso se le instruye la respuesta requerida, para cada señal específica de entrada.

ESQUEMA: ESTÍMULO-RESPUESTA

Funciona en arquitecturas de una y más capas (presencia de unidades sin contacto externo) La modificación de los parámetros (pesos sinápticos) se realiza, en general, por medio de optimización por descenso de gradiente.

APRENDIZAJE NO‑SUPERVISADO Y AUTOORGANIZATIVO

La no‑supervisión

indica la ausencia de un maestro externo, el cual se compensa con la

competencia o cooperación entre UU. P. vecinas por responder a un estímulo.

Este proceso conduce a un agrupamiento de la información.

La autoorganización requiere de la definición de una función de energía (Lyapunov) dependiente de las variables de estado del sistema. El aprendizaje se torna en una suerte de relajación del sistema a un estado de mínima energía.

Sección de una Red Neuronal Natural

Se ejemplifica una red neuronal natural existente en la retina y que procesa previamente la información que tiene acceso al nervio óptico. Ejemplifica una arquitectura de red a capas, Los fotoreceptores son las unidades de entrada, mientras que las neuronas del nervio óptico constituyen las salidas.

Diagrama en Bloques de un Sistema de Procesamiento Basado en una Red Neuronal Artificial

Primer Modelo Histórico de una

Neurona (McCulloch y Pitts, 1943)

Aspectos del modelo de McCulloch y Pitts

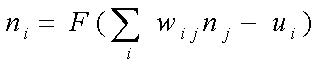

Para una red conformada por esta clase de UU. P. las actividades se evalúan en tiempo discreto, de acuerdo con las siguientes ecuaciones:

Se ha demostrado que una configuración sincrónica de UU. P. de este tipo tiene la capacidad de computación universal.

A este modelo se le pueden imputar las siguientes deficiencias básicas:

i) No se indica en la teoría cómo se organiza el dispositivo o cómo se ajustan los pesos y umbrales de las UU. P. En otras palabras, no se incluye ningún proceso de aprendizaje.

ii) No son sistemas robustos, ya que están supeditados al funcionamiento de todas sus partes. Al contrario de su inspiración natural, son muy sensibles a las fallas.

iii) Son muy simples, omiten muchos aspectos interesantes de las neuronas.

i)

Las

neuronas reales no son, en lo más mínimo, unidades de umbral. Son más

bien unidades de respuesta continua.

ii)

Es de importancia

la relación no‑lineal entre la entrada y la salida (constituye un rasgo

universal en las neuronas).

iii)

El

"cómputo" es más complejo, puede hasta llegar a ser una sumatoria no‑lineal

con apreciable procesamiento dendrítico previo.

iv)

Responden

con una secuencia de pulsos, no con un solo nivel de salida representativo del

índice de disparo.

v)

Aun con una salida continua, se ignora mucha información,

tal como la fase de la secuencia de pulsos.

vi)

No todas las neuronas responden con un retardo constante, t ® t + 1. Tampoco son sincrónicas, siguiendo un reloj

central.

vii)

La

cantidad de neurotransmisores segregados en una sinapsis puede variar de manera

impredecible. Por lo que el modelado podría involucrar una componente

estocástica en la dinámica.

Se han propuesto generalizaciones.

Esquema de Una Unidad Básica de Proceso (Esquema de Orden Cero de una Neurona)

Aspectos de la Unidad Básica de Proceso

i) Tanto la activación (Act) como la salida (Sal) que denota el estado del sistema, son números continuos en un rango particular.

ii) La función de transferencia es una función no‑lineal más general.

iii) No suele involucrarse el tiempo explícitamente, más bien se especifica una regla de actualización de los estados de las UU. P. (por ejemplo, de manera asíncrona a tiempos aleatorios)

Algunas Funciones de Transferencia Comúnmente Utilizadas